轉載從: Tech News 科技新報

對大部分人來說,透過說話交流是理所當然的事。但世界還有一部分群體,他們由於先天或後天原因,無法做到我們認為理所當然的事。對有聽覺與語言障礙的人來說,手語才是交流的方式。

問題是,手語雖然解決交流問題,但對習慣說話的大部分人來說,手語和外星語言可能沒什麼差別。如何便利地將手語轉化成口語,成為近年來新的研究課題,Google AI 實驗室的新演算法可能成為解決問題的新方案。

新技術採用一些巧妙的方法,且隨著機器學習效率越來越高,僅使用手機就能做道高精確度的手部與手指追蹤,帶來很多新可能性。

「目前最先進的方法都是依賴效能強大的桌機環境,而我們的方法可在手機做到即時追蹤,甚至能延伸到多手部。」Google 研究人員於官方部落格寫道。強悍的手部追蹤演算法是具挑戰性的電腦視覺工作,因手部經常會被動作遮擋,且缺乏高對比模式。

不僅如此,手部動作通常速度很快且微妙,這不是電腦擅長的即時追蹤,即便使用多鏡頭和深度感測裝置的 SignAll,追蹤每個動作依然很困難。

在這種情況下,研究人員只能盡量減少電腦需篩選的資料量,才能提高反應速度和追蹤精確度。

首先,他們放棄追蹤整個手部大小和位置,相反地,讓系統只找到手掌部位,這不僅是手最獨特可靠的部分,且接近矩形,這意味著系統不用處理大量複雜的圖案。

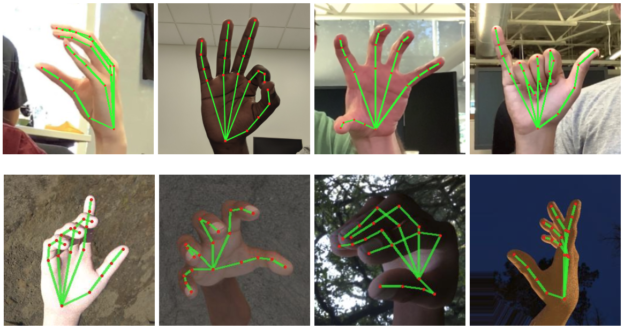

當手掌首先辨識時,延伸出的手指會單獨辨識和分析,一個單獨演算法將之配置為 21 個座標,大致描繪指關節及指尖,包括手指部分伸出多遠,且系統還可根據手掌大小和角度猜測。

為了完成手指辨識部分,研究人員必須手動將這 21 個座標點加到各種姿勢和光照條件下約 3 萬張手掌圖。就像往常,每個強悍的機器學習系統開始階段都需要研究人員大量辛苦的餵資料。

確定手姿勢後就簡單了,將這些姿勢與已知的手語含義連結,從簡單的字母、數字直到具特定含義的手勢都包括。最後,一種反應迅速且準確的手勢辨識演算法誕生了,且可在智慧手機執行而不是桌機端。

這種演算法出現還能改進現有的辨識系統,不過距離 AI 真正理解手語依然還有很長的路要走,因為這是使用手勢、臉部表情和其他細節呈現的與眾不同的交流形式。但現在我們正向越來越好的方向前進。

最後 Google 研究人員說:「我們希望向更廣泛的研究和開發社群提供這種手勢感測功能,並期望創造性案例出現,以刺激新應用和研究途徑。」

(本文由 愛范兒 授權轉載;首圖來源:Google AI )