轉載從: Tech News 科技新報

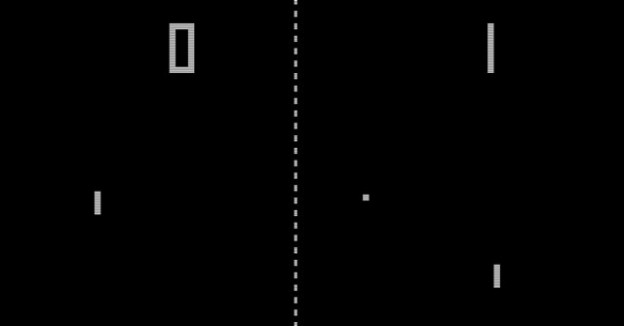

Hardcore 級的電玩高手要小心了,繼西洋棋後,有機會打敗你們的人工智慧已經誕生。Google 擁有的人工智慧研發公司 DeepMind,僅利用一台電腦的演算能力,展現了如何學習 49 款街機遊戲,其中包含史上第一款街機遊戲《乓》(Pong,上圖) 與經典《太空侵略者》(Space Invaders),而其中已有一半遊戲,人工智慧的功力已經可以打敗真人高手。

這套首次於 2013 年發表的演算法,是第一套針對不同目標(遊戲)學習,且在一開始只需要給少量資料就能自行運作的演算法。美國詹姆斯麥迪遜大學 (James Madison University) 人工智慧專家 Nathan Sprague 說,一套系統就能學習不同遊戲,且轉換之間不需要調整什麼,這是多麼令人印象深刻的事。

雖然 IBM 的「深藍」(Deep Blue) 於 1997 年就已經擊敗當時的世界西洋棋王卡斯波洛夫 (Garry Kasparov);不久前加拿大也開發出一款德州撲克人工智慧演算法,號稱「在公平的遊戲中不會輸」,但他們都有一個限制:只精通一款遊戲。

這項發表在「自然」雜誌的最新成果,DeepMind 其實是結合兩套人工智慧學習系統而成。第一種叫「深度學習」(Deep Learning),將可以加強累積經驗的模擬神經元,以多層次方式組合並連接在一起,這與腦部神經細胞彼此用突觸連接的方式很像。深度學習系統可以從大量沒有結構化的資料中獲取複雜的資訊,Google 的翻譯及照片分類功能就是採用類似的架構。

▲《太空侵略者》

▲《太空侵略者》

第二種叫「強化學習」(reinforcement learning),是一種模仿神經傳遞物質「多巴胺」運作的決策系統,它收集遊戲畫面中的像素資料與得分,判斷進行什麼動作可以得到較多分數,例如往左、往右或是射擊;套句電玩術語,「練功」,也就升級了。

DeepMind 共同創辦人 Demis Hassabis 表示,神經學家一直在研究人類的智能及決策過程,這套靈感來自大腦運作方式發展出的演算法,正好可以協助進行這方面的研究。像 Google 這樣的公司本身當然也需要不斷精進的人工智慧系統,協助他們判斷如何以最有效益的方式投放廣告或聚焦內容;而對於實體機器人來說,當然可以讓他們更聰明地與真人及環境互動。

DeepMind 的下一步也令人眼睛一亮。研究團隊計畫加入記憶功能,讓演算法有「觸類旁通」的能力,也就是說,目前的版本其實是演算法各自在學 49 款遊戲,彼此的學習結果並沒有互通,有了記憶能力,很多「白工」可以省下。另一個計畫則是把 DeepMind 變成「眼光短淺」的傢伙。因為目前的演算法都是著眼於一個「遙遠」的目標,研究團隊必需要讓它具備解決更小規模目標的能力,才有辦法玩像《小精靈》(Ms. Pac-Man) 這種迷宮遊戲。

▲《小精靈》

(圖片來源:Wikimedia Commons)

相關資訊

- Human-level control through deep reinforcement learning

- Game-playing software holds lessons for neuroscience