轉載從: Tech News 科技新報

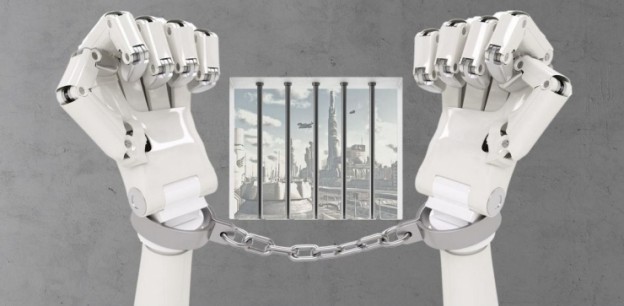

關於人工智慧倫理問題,特別是涉及到開發機器人武器之類的問題,我們已經討論過很多次了。實際上,之前我們更多是把人工智慧作為一種人類已知威脅來展開討論的。那些喜歡電影《魔鬼終結者》的粉絲應該對它的情節還記憶猶新吧,片中人工智慧「天網」希望終結人類,如果這一幕真的發生,那麼我們現在討論什麼監管啊、責任啊,似乎都毫無意義。但所謂千里之堤毀於蟻穴,尤其在法律哲學家 John Donaher 的眼裡,如果能夠仔細思考這些問題的話,說不定會有助於減少未來可能存在的風險。

人工智慧的監管與責任,其實和安全與公共福利一樣,都像是硬幣的正反面。監管的目的,是為了確保人工智慧系統盡可能的安全;而責任,其實就是為了當人工智慧系統出錯時,我們可以找到可以追究問題的人,或者再說得準確一點,就是找誰可以獲得法律上的賠償。

應該向誰追責呢?

讓我們先來談談責任問題吧。首先,我們可以模擬一個侵權(民事)責任問題,想像下,在不遠的將來可能會發生這樣一個場景:一輛無人駕駛牽引機原本應該按照指令在 A 農民的田裡播種,但是奇怪的是,它卻把種子播種到了 B 農民家的田裡。

讓我們先假設 A 農民是完全按照操作手冊來使用那輛無人播種牽引機的,同時,我們也假設 A 農民無需再做其他額外的操作,比如在農田交界處設置無線電信標等。那麼現在,假設農民 B 要來控告這次錯誤播種事件(我們暫且不考慮諸如滋擾和侵犯等問題),會遇到哪些問題呢?

實際上,有很多問題需要被回答,這個事故是農民 A 的責任嗎?可能不是;那麼,是無人播種牽引機廠商的責任嗎?有可能,但在此之前,我們是不是該明確與這些問題相關的責任和標準呢?比如無人播種牽引機的行業標準是什麼,製造商的產品規格是否符合相關標準呢?不僅如此,如果自己的土地被他人種植上了其他農作物,這是否算是財產損失,又是否能否追溯經濟賠償呢?

在一連串問題之前,我們其實是先假定了無人播種牽引機裡面的系統軟體是由製造商開發的。那麼接下來又有新的問題出現了,如果那套人工智慧系統是由協力廠商開發公司完成開發的,該如何處理?還有,系統內部的軟體代碼是由多人合作完成的,又該如何界定各自的職責?

隨著時間的推移,人工智慧系統將會越來越不依靠傳統的經典演算法和代碼,而且他們也會產生更多我們無法預料到的行為,值得一提的是,這些行為沒有人可能預測得到,甚至包括人工智慧系統的創造者也無法預料。但重要的是,可預見性,其實是處理責任過失問題中一個非常關鍵的組成部分。

為了能夠讓讀者更好地理解可預見性問題,我們才會假設了上面那個無人播種牽引機的案例,或許十年、二十年之後,人工智慧已經不再是簡單的種錯莊稼這件事了,它可能會是某個意外讓人們受傷,更嚴重一些,人工智慧可能會不小心殺人。所以,如果我們的法律無法適時作出改變,那麼未來將會導致更多問題出現。就拿上面那個人工智慧種錯莊稼的事情為例,當無法實現可預見性,最終的結果就是沒人承擔責任!

責怪人工智慧機器人

為什麼我們不乾脆去責怪機器人呢?畢竟,關於人工智慧人格也有過討論,而且人工智慧系統本身也有擔負刑事責任的可能。

但是,這種方法在實際應用時又有什麼不一樣呢?這裡,還是借用別人曾經說過的一句話吧。「人工智慧系統真的會像著名小說家艾薩克·阿西莫夫筆下的機器管家那樣嗎?遵守法律,遵從道德良知,還能保護銀行存款?」

我們姑且不去討論人工智慧系統是否可以被起訴,但人工智慧製造商和開發商們必須受到監管。只有這樣,才有可能將一些無法歸責的各方,用嚴格責任賠償(註:嚴格責任賠償是指只要造成了損害,不論行為人有無過錯,都要承擔賠償責任。 常見的適用於無過錯責任原則的,有從事高壓、劇毒、高速、放射等作業造成他人損害的。工傷是典型的適用無過錯責任原則的,也就是說只要勞動者在工作期間因公受傷了,排除勞動者個人主觀故意的因素之外,雇用單位無論有無過錯都要承擔工傷賠償的責任的。)約束起來。

實際上,在我們的日常生活裡,嚴格責任賠償已經應用到了很多地方。當然除了這種責任賠償之外,如果需要對人工智慧追責,其實也可以採用無過錯責任賠償和賠償方案池等方式。

規章制度

如果從監管的角度來看人工智慧,那麼你會發現,嚴格的安全標準,以及建立完善的安全認證流程也都是非常必要的。不過,如何設計一個合適的機構與流程框架,並且讓這個框架得以有效運行,依然是一個非常棘手的問題。

人工智慧領域複雜難懂,而且外部世界對於人工智慧研發圈子普遍缺乏認識,這也就是人工智慧專家需要盡快創建行業框架的原因所在。實際上,這裡所說的框架,就是規章制度,說通俗些也就是遊戲規則。因此,這意味著人工智慧顧問委員會需要和政府一起,盡快立法,建設行業標準。

我們不得不承認,人工智慧行業存在巨大的潛在效益;但是標準和流程,需要不斷的創建、更新、並且執行,這樣才能達到一種持續性平衡,繼而最大限度地提高公共福利和安全;當然,也只有這樣,才不會扼殺創新,更不會出現不必要的法律負擔。

事實上,站在國家的角度上,建立任何一個法律框架或遊戲規則,都必須要足夠靈活,監管機構不僅需要考慮到本國利益,也要從全球角度出發。這意味著在某種程度上,你不僅要考慮本國的人工智慧產量,以權衡進口其他各國人工智慧技術,同時,你還要思考該如何任何不同國家之間的安全標準和認證,必要的時候,你是否還需要遵守未來可能出現的國際條約或公約等。所有這一切,遠比我們想像的要複雜得多。

因此,當我們沿著人工智慧研發的道路上前行,圍繞人工智慧構建規章制度是必須要去做的事情,不要當一切都來不及時再後悔莫及。

現在,我們已經開始對無人駕駛汽車所涉及到的問題展開討論了,那麼未來人工智慧還需要受到哪些法律法規的約束呢?

(本文由 雷鋒網 授權轉載)