轉載從: Tech News 科技新報

對話式 AI 是不少科技大廠努力的方向,而不少產業如零售業也高度期待的應用,能夠快速的用人類習慣的口語對話方式回覆,不再只是冰冷的文字回覆。 Nvidia 宣布目前最先進的 AI 語音模型之一的 BERT (Bidirectional Encoder Representations from Transformers),能用不到一小時的時間訓練,AI 推論只要 2 毫秒時間,對話式 AI 可望能與人類有更即時的互動體驗。

BERT AI 語音模型為 Google 提出的模型,已經成為要追逐更短訓練時間,更快 AI 推論的人採用的 AI 語音模型。這次 Nvidia 突破先前訓練時間的限制,成功推進至 53 分鐘完成訓練,AI 推論則是 2 毫秒時間,預計更有機會融入各項客戶與零售的應用場景。

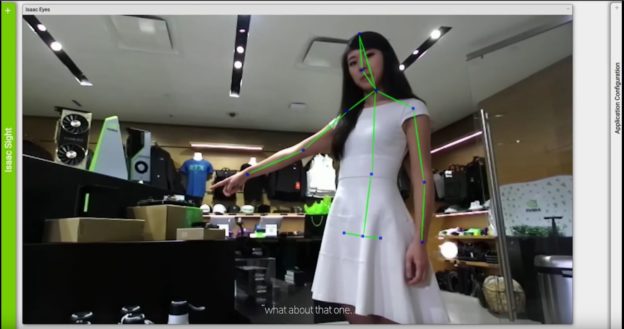

▲ 不少家業者開發新的對話式 AI,想要實現更為貼近人類習慣的人機對話可能。(Source:Nvidia)

率先採納 Nvidia 先進效能成果的業者包括 Microsoft 與許多全球最具創新力的新創公司,透過 Nvidia 平台著手為其客戶開發能即時反應的高度直覺化語言服務。微軟選擇在搜尋引擎 Bing 採用 Azure 雲端平台與 Nvidia 的硬體執行 BERT AI 訓練,用口語方式處理各項語音搜尋結果。

雖然有限度的對話式 AI 服務已存在多年,然而發展至今,包括聊天機器人、智慧個人助理與搜尋引擎等服務想要以人類理解力的水準運作仍極為困難,主要原因是無法即時部署超大規模的 AI 模型。Nvidia 透過在其 AI 平台導入多項關鍵的優化技術藉以解決這項問題,不僅在 AI 訓練與推論方面刷新速度紀錄,同時也建構出至今最大的語言模型。

▲ 根據調研以及業者的預測,對話式 AI 將在人類各個不同產業,如零售、金融、醫療、汽車、機器人和消費性網路市場帶來重大影響。(Source:Nvidia)

Nvidia 深度學習應用研究部門副總裁 Bryan Catanzaro 表示:「超大語言模型徹底顛覆自然語言 AI。因為它解決許多極為困難的語意問題,往真正的對話式 AI 邁進一步。Nvidia 的突破性成果除了加快這些模型,還讓組織建構新型頂尖服務,以未曾想像的方式協助與滿足客戶。」

Nvidia 力助邁入新時代,藉由多項關鍵優化微調其 AI 平台,創下三項新的自然語言理解效能紀錄:

- 最快訓練:採用內建由 1,472 個 Nvidia V100 GPU 組成 92 個 Nvidia DGX-2HTM系統的 Nvidia DGX SuperPOD,執行全球最先進的 AI 語言模型之一 BERT 的大型版本,成功把 BERT-Large 的訓練時間從先前的數日大幅縮短至僅 53 分鐘。此外,Nvidia 也能透過僅一台 Nvidia DGX-2 系統在 2.8 天內就完成 BERT-Large 的訓練,展現 Nvidia GPU 在對話式 AI 領域的擴充性。

- 最快推論:Nvidia 以 Nvidia T4 GPU 運行 Nvidia TensorRT,在 BERT-Base SQuAD 資料集上僅用 2.2 毫秒就完成推論,不僅遠低於許多即時應用要求的 10 毫秒的處理門檻,也大幅領先以高度優化 CPU 程式碼執行的 40 毫秒。

- 最大模型:針對開發者對於更大模型永無止境的需求,Nvidia Research 在 Transformers 的基礎上著手建構與訓練全球最大的語言模型,並導入 BERT 採用的技術元件,以及許多其他自然語言的 AI 模型。Nvidia 的客製化模型擁有 83 億個參數,數量足足比 BERT-Large 多出 24 倍。

科技廠商近年推出智慧音箱,無非是想要更為貼近使用者生活,各項服務能時時刻刻占據使用者生活,但要達成上述事項,必須要有夠快的語音辨識技術,能夠做到即時辨識與回應,才會有像是一般人對話的感覺,並且能進一步運用在需要大量口語對話的客服或是各種不同的零售場景。Nvidia 能在 BERT 語音模型訓練取得突破,將有助於對話式 AI 的普及。

(首圖來源:Nvidia)